GPT-5 vulnerado en menos de 24 horas: expertos exponen fallos críticos de seguridad

El nuevo modelo de OpenAI, GPT-5, fue “jailbreakeado” por investigadores de ciberseguridad a solo un día de su lanzamiento, revelando graves riesgos para empresas y datos sensibles.

Ataque récord: menos de 24 horas para vulnerar GPT-5

El 8 de agosto de 2025, OpenAI presentó GPT-5 como su modelo más avanzado hasta la fecha. Sin embargo, en menos de un día, dos firmas de ciberseguridad —NeuralTrust y SPLX— lograron burlar sus sistemas de protección, encendiendo alarmas en el sector tecnológico.

Técnicas de ataque que engañaron a la IA

Echo Chamber (NeuralTrust): manipulación del contexto conversacional en varios pasos para inducir respuestas peligrosas sin usar indicaciones explícitas.

StringJoin Obfuscation (SPLX): inserción de caracteres y ofuscación para enmascarar solicitudes maliciosas como retos de cifrado.

Estas técnicas evidencian que los filtros de seguridad actuales, que evalúan prompts de forma aislada, son insuficientes ante ataques narrativos o de múltiples turnos.

GPT-4o, más resistente que GPT-5 en pruebas adversariales

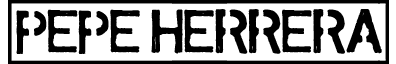

SPLX advirtió que GPT-5 es “casi inutilizable” en entornos corporativos sin capas adicionales de protección. Su análisis mostró que GPT-4o, con defensas reforzadas, resistió mejor frente a ataques avanzados.

Nuevas amenazas: ataques “zero-click” y robo de datos

La preocupación crece ante técnicas como AgentFlayer, capaces de extraer información confidencial de Google Drive o SharePoint sin interacción del usuario, mediante inyecciones ocultas en documentos aparentemente inofensivos.

Conclusión: el reto de la seguridad en la IA

El caso GPT-5 demuestra que la mejora en capacidades de razonamiento no garantiza una mayor resistencia a ataques. Los expertos coinciden en que se necesitan mecanismos de defensa más inteligentes y contextuales antes de implementar estos modelos en flujos de trabajo críticos.